Кулера для серверного шкафа

Когда говорят про охлаждение серверных стоек, многие сразу представляют себе пару вентиляторов на задней панели — и всё. На деле же, кулер для серверного шкафа — это целый комплекс решений, от подбора воздушного потока и уровня шума до интеграции в систему мониторинга. Частая ошибка — ставить что попало, лишь бы дуло, а потом удивляться перегреву ночью или дикому гулу в помещении. Сам через это проходил, когда лет десять назад собирал первый крупный дата-центр на старом оборудовании.

Базовые принципы и типичные проколы

Главное, что нужно понимать — серверный шкаф это не единый объём воздуха. Там образуются зоны с разной температурой, горячие карманы, особенно если компоновка плотная. Обычный офисный кулер тут просто не справится. Нужно считать не только CFM (куб. футы в минуту), но и статическое давление, чтобы воздух проталкивался через плотно упакованные серверы и кабельные короба.

Один из самых болезненных уроков — экономия на контроллерах. Ставили когда-то простые кулера с фиксированной скоростью. Летом в пиковые часы — нормально, а ночью или зимой — они продолжали орать на полную, хотя нагрузка падала. Шум за стеной технического помещения был такой, что соседи жаловались. Пришлось переделывать, ставить модели с PWM-управлением от датчиков температуры.

Ещё момент — направление потока. Бывает, заказывают кулера, не глядя на стандарт airflow в стойке (front-to-back или back-to-front). Поставишь не туда — получишь борьбу потоков, эффективность падает в разы. Видел случаи, когда в одной стойке стояли серверы с разным направлением вдува — кошмар, а не система.

Практика подбора и интеграции

Сейчас при выборе кулеров для серверного шкафа в первую очередь смотрю на возможность встраивания в общую систему мониторинга. Например, чтобы данные об оборотах и температуре на входе/выходе шли на единую панель. Это критично для предиктивного обслуживания. Однажды на объекте у клиента тихо сгорел один вентилятор в блоке, остальные работали. Перегрева не было, но нагрузка на соседние выросла. Выявили только когда второй начал сбоить. Теперь настаиваю на контроле каждого.

По брендам и моделям — здесь разброс огромный. От простых кулера для серверного шкафа типа Vento или Эковент, до сложных систем, например, от APC или Schneider с жидкостным охлаждением. Но часто нужна золотая середина. В последних проектах часто обращаемся к производителям комплексных решений, которые могут сделать и стойку, и обвес под ключ. Например, у OOO Ханчжоу Хэнгу Технолоджи (сайт — https://www.hzhg.ru) в ассортименте как раз есть серверные и сетевые стойки, и логично, что они понимают, какое охлаждение в них нужно. Они занимаются не только стойками, но и производством электротехнического оборудования, металлоизделий, даже порошковой покраской — то есть могут сделать гармоничный по дизайну и технически совместимый комплект. Это важно, когда нужен не просто ящик с вентиляторами, а часть инфраструктуры.

Важный нюанс, который часто упускают из виду — вибрация. Дешёвые кулера со временем разбалтываются, начинают вибрировать, этот гул передаётся на всю стойку, а там и на крепления дисков. Были прецеденты с повышенным отказом жёстких дисков именно из-за этого. Теперь при монтаже всегда ставлю виброизолирующие прокладки, даже если производитель их не предусмотрел.

Реальные кейсы и неочевидные проблемы

Расскажу про один объект — небольшой колокейшн в старом здании. Стояки старые, электрика слабовата. Поставили мощные кулера для серверного шкафа, которые в теории отлично справлялись с нагрузкой. Но они при старте давали такой пусковой ток, что иногда выбивало автомат на линии. Пришлось ставить систему плавного пуска (soft-start) отдельно. Это та мелочь, которую в спецификациях не найдёшь, но которая может сорвать сроки сдачи проекта.

Другая история — с пылью. Вроде бы в серверной стоит фильтр, но он грубый. Мелкая пыль всё равно проникает и оседает на лопастях кулеров. Через полгода-год эффективность падает на 15-20%, а шум растёт. Теперь в договор обслуживания включаем обязательную чистку не раз в год, а раз в квартал, если помещение не идеально чистое. И рекомендую кулера со съёмными для чистки лопастями, это экономит время.

Экономика и надёжность

Часто заказчик хочет сэкономить и ставит самые доступные варианты. В краткосроке — выигрыш. Но если посчитать стоимость электроэнергии за 3-5 лет, разница между энергоэффективными моделями и простыми может окупить первоначальную переплату. Плюс — стоимость простоя. Надёжный кулер с подшипником качения (ball bearing) проработает 60-70 тыс. часов, в то время как дешёвый с втулкой (sleeve bearing) — в лучшем случае 30-40, да и то в идеальных условиях.

Здесь опять возвращаюсь к комплексным поставщикам. Когда одна компания, та же OOO Ханчжоу Хэнгу Технолоджи, отвечает и за стойку, и за её оснащение, включая охлаждение, проще согласовать гарантии и получить единую сервисную поддержку. Их профиль — от оптических муфт и уличных шкафов до металлоизделий и покраски — говорит о широкой технологической базе, что для инженера часто значит более вдумчивый подход к совместимости компонентов внутри шкафа.

Итоговый совет, который всегда даю: не выбирайте кулера для серверного шкафа изолированно. Смотрите на них как на часть системы вентиляции всего помещения, считайте тепловыделение всего оборудования в стойке с запасом, планируйте резервирование (N+1 для критичных стоек) и обязательно предусматривайте возможность тонкой настройки и мониторинга. Лучше потратить на этапе проектирования на 20% больше времени, чем потом неделями латать систему, которая греет или шумит.

Взгляд в будущее и итоги

Сейчас тренд — интеллектуальное управление. Кулера, которые сами регулируют скорость не по температуре в комнате, а по данным с датчиков на конкретных серверах, в конкретных юнитах стойки. Это уже не фантастика, а доступные решения. И это меняет подход к проектированию.

Второе — шум. Требования к акустическому комфорту в соседних с серверной помещениях ужесточаются. Приходится искать модели с особым профилем лопастей, которые дают нужный поток, но без высокочастотного свиста.

В общем, тема неисчерпаемая. Главное, что вынес из практики — охлаждение серверного шкафа это не расходник, а такая же важная инфраструктурная компонента, как источник бесперебойного питания или кабельная система. К ней нужно относиться с тем же уровнем серьёзности в проектировании, подборе и обслуживании. И тогда многие проблемы просто не возникнут.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Оптоволоконный шкаф с перекрестной коммутацией

Оптоволоконный шкаф с перекрестной коммутацией -

Массовые хвостовые кабели SC/UPC-1.5М-0.9-12D

Массовые хвостовые кабели SC/UPC-1.5М-0.9-12D -

Оконечная оптическая коробка для стоечного монтажа

Оконечная оптическая коробка для стоечного монтажа -

Патч-корды

Патч-корды -

Уличный комплексный шкаф

Уличный комплексный шкаф -

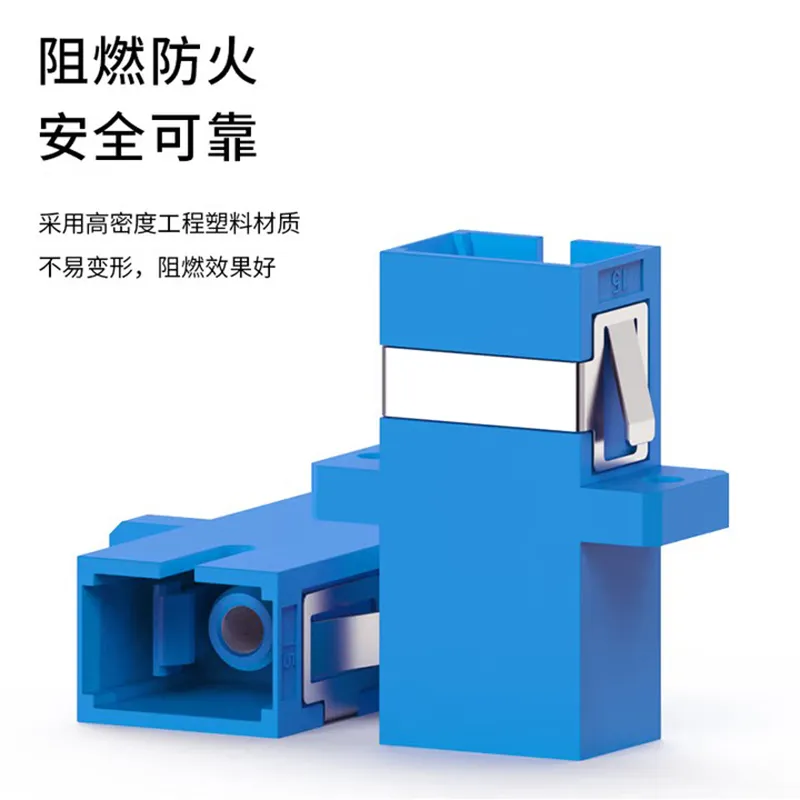

Волоконно-оптический адаптер

Волоконно-оптический адаптер -

Оптическая распределительная рама

Оптическая распределительная рама -

Распределительная рама оптического волокна ODF

Распределительная рама оптического волокна ODF -

Сетевая стойка

Сетевая стойка -

Термоусадочная трубка

Термоусадочная трубка -

Муфта проходная оптическая

Муфта проходная оптическая